KÜNSTLICHE INTELLIGENZ IM GERÄT MIT QUALCOMM SNAPDRAGON

28. Mai 2019 | Planegg

Künstliche Intelligenz ist die Wachstumsmöglichkeit der kommenden Jahre.

Bei den meisten Produkten wird die Intelligenz auch heute noch in der Cloud berechnet. Diese Berechnungen werden dann an Geräte gesendet und dort vom Anwender verwendet.

Das bekannteste Beispiel ist in diesem Fall wahrscheinlich Amazon Alexa. Für die Sprachsteuerung ist weiterhin eine permanente Internetverbindung erforderlich.

Der Vorteil von Künstliche Intelligenz (KI)-Anwendungen, die in der Cloud gehostet werden, ist der Zugriff auf eine viel höhere Rechenleistung und viel größere Datenmengen, was zur Verbesserung der KI-Algorithmen beiträgt. Einige Live-Informationen sind auch nur in der Cloud verfügbar (z.B. Wettervorhersage). Das alles kostet Strom und Bandbreite und entstehende Bedenken hinsichtlich Sicherheit und Datenschutz.

Für den professionellen Bereich, wie beispielsweise industrielles IoT oder autonomes Fahren, sind die Herausforderungen noch größer, da die Anforderungen an Latenz, Zuverlässigkeit und Sicherheit deutlich steigen.

Da die Prozessoren immer leistungsfähiger werden, kann heute eine große Anzahl von KI-Anwendungen direkt auf den Geräten berechnet werden. In den meisten Fällen wird eine Kombination aus beiden Technologien verwendet. Echtzeitanwendungen und kritische Anwendungen werden auf den Geräten berechnet und regelmäßig mit neuen Informationen aus der Cloud aktualisiert.

Diese Informationen können einfache Updates sein, aber auch Algorithmenverbesserungen werden zwischen den Geräten ausgetauscht. Die Benutzerdaten werden jedoch nicht direkt in die Cloud übertragen, was den Datenschutz, die Latenzzeit und die Zuverlässigkeit deutlich verbessert. Und nicht zuletzt kostet die Bandbreite Geld und Ressourcen, die eingespart werden können.

Der Trend geht dahin, dass Geräte im IoT immer intelligenter werden müssen, da sie schneller reagieren, weniger Strom verbrauchen und sicherer werden müssen.

Die Herausforderung bei der Übertragung von KI-Anwendungen aus der Cloud oftmals auf mobile Geräte besteht darin, die Anforderungen an das KI-Computing mit den Einschränkungen der Geräte in Einklang zu bringen.

Die KI benötigt eine Menge Rechenleistung, die verfügbar sein muss. Je komplexer die Anwendungen werden, desto größer und komplizierter werden die Modelle neuronaler Netze.

Diese müssen in Echtzeit verarbeitet werden können und kontinuierlich verfügbar sein.

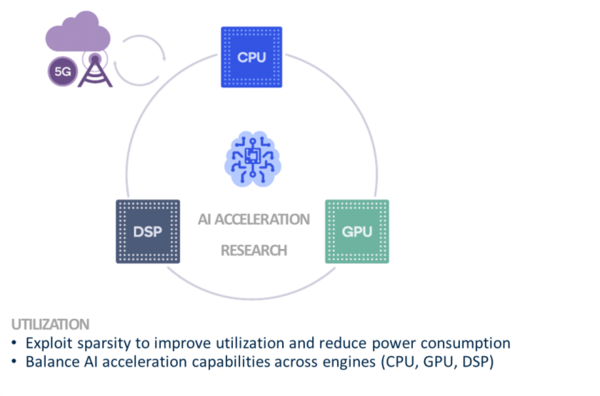

Andererseits gibt es Einschränkungen bei den Geräten. Beispielsweise sind Strom und Batterie begrenzende Variablen und fortschrittliche Rechenalgorithmen sind leistungshungrig. Diese Anforderungen werden am besten erfüllt, indem die unterschiedlichen Stärken der verschiedenen Computerarchitekturen genutzt werden.

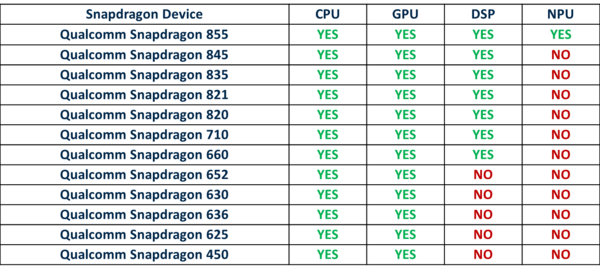

Für Qualcomm Snapdragon-Systeme wird die benötigte Rechenleistung auf die verschiedenen Chip-Komponenten CPU, GPU und DSP verteilt. Mit den neuesten Chips wird auch eine NPU hinzugefügt, die speziell für die Berechnung von KI-Anwendungen entwickelt wurde. Dies bietet enorme Vorteile in Bezug auf Rechengeschwindigkeit, Echtzeit und Stromverbrauch.

Qualcomm bietet mit der Snapdragon Neural Processing Engine (SNPE) eine softwarebeschleunigte Laufzeit für die Ausführung von tiefen neuronalen Netzwerken (für Schlussfolgerungen) an.

Das SNPE SDK bietet alle erforderlichen Tools für die Entwicklung neuronaler Netze auf Basis der Snapdragon-Technologie.

Mit dem SNPE, können Anwender:

- Konvertieren von Caffe/Caffe2, ONNX und TensorFlow Modelle in eine SNPE Deep Learning Container (DLC) Datei.

- Quantisieren von DLC-Dateien auf 16/8 Bit Fixpunkt für die Ausführung auf dem Qualcomm® HexagonTM DSP.

- Ein Netzwerk in Anwendungen und anderen Code über C++ oder Java integrieren.

- Ausführen des Netzwerks auf der Snapdragon CPU, dem Qualcomm® AdrenoTM GPU oder dem Hexagon DSP mit HVX*-Unterstützung.

- Ausführen eines beliebig tiefen neuronalen Netzwerks

- Debuggen der Ausführung des Netzwerkmodells auf x86 Ubuntu Linux

- Debuggen und Analysieren der Performance des Netzwerkmodells mit SNPE-Tools

- Benchmarking eines Netzwerkmodells für verschiedene Ziele

Die Software ist so konzipiert, dass sie mit den Hexagon Vector eXtensions optimal auf die Snapdragon-Prozessortechnologien CPU, GPU und DSP verteilt ist.

Die heutigen gemeinsamen Rahmenbedingungen für den Aufbau neuronaler Netze wie TensorFlo und Caffe 2 werden unterstützt.

Darüber hinaus stehen eine Vielzahl von Optimierungs- und Debugging-Tools zur Verfügung.

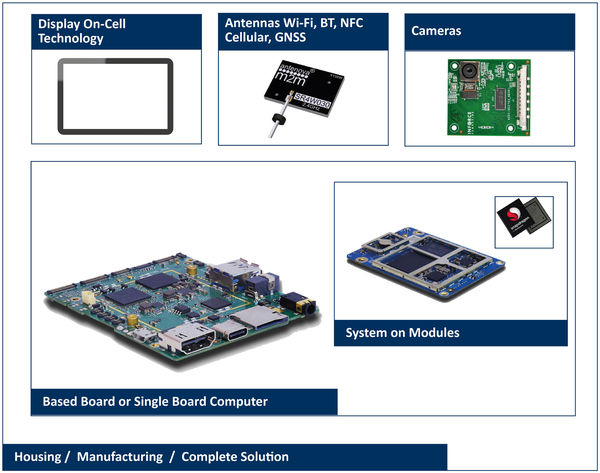

Atlantik bietet Plattformen für verschiedene Anwendungen. Diese bieten Anwendungsentwicklungskits, die die Entwicklung wesentlich erleichtern und die KI-Entwicklung ermöglichen, ohne die Hürden für das Design von KI-Algorithmen überwinden zu müssen. Stattdessen steht eine große Anzahl von Beispielen und Beispielcode zur Verfügung.

Atlantik Elektronik - Anbieter von KI-Technologie Geräten & Dienstleister

- KI Technologie und Dienstleistungen

- KI Algorithmenentwicklung, Optimierung, Training

- KI-Berechnungsmodule: 625/820/835/660/845

- System und Lösung

- Smart Retail, Smart Manufacturing, Smart Car, etc.

- Entwicklung von Komplettlösungen